Uitleg van AI-modellen voor iedereen

Explainable AI

Inhoud van pagina

Introductie

Steeds meer organisaties introduceren kunstmatige intelligentie (AI) en machine learning in hun bedrijfsvoering. Deze introductie levert veel voordelen op. Bijvoorbeeld taken kunnen sneller en efficiënter worden uitgevoerd, AI ondersteunt besluitvorming door processen slimmer te maken en het helpt bij het verminderen van fouten.

Toch levert de introductie van kunstmatige intelligentie ook nieuwe uitdagingen op. Een daarvan is het vertrouwen van de uitkomsten van een AI-model.

Waarom is zo’n uitleg zo belangrijk? Als het gaat om voorspellende modellen, moet u een afweging maken: wil u gewoon weten wat er wordt voorspeld? Bijvoorbeeld de kans dat een klant zal vertrekken of hoe effectief een medicijn zal zijn voor een patiënt. Of wil u weten waarom de voorspelling is gedaan en eventueel inleveren op de voorspellende prestatie voor een uitleg?

Er komt geen AI-model meer in het publieke domein, zonder dat deze uitlegt hoe de conclusie tot stand is gekomen.Joop Snijder, Area Lead Data & AI bij Info Support

Wat is Explainable AI?

Explainable AI wordt in het Nederlands ook wel verklaarbare AI of uitlegbare AI genoemd. De Engelse afkorting wordt ook gebruikt, namelijk XAI (eXplainable Artificial Intelligence). Explainable AI is, kort gezegd, een concept waarbij de beslissingen van Artificial Intelligence transparant worden gemaakt voor menselijke experts. Dit in tegenstelling tot ‘black box’- systemen. Om te begrijpen hoe dit werkt, kijken we eerst naar hoe AI-systemen leren.

Hoe leert AI regels

AI-systemen optimaliseren hun gedrag om te voldoen aan een wiskundig gespecificeerd algoritme gekozen door de ontwikkelaar, zoals “maximaliseer de nauwkeurigheid van de beoordeling hoe positief filmrecensies zijn”. De AI kan nuttige algemene regels uit de gegevens leren, zoals “beoordelingen met het woord ‘verschrikkelijk’” zijn waarschijnlijk negatief. Het kan echter ook ongewenste regels leren, zoals “beoordelingen met ‘Will Smith ‘zijn meestal positief”.

Hoe de AI tot deze regels komt is onduidelijk. Het is duidelijk en exact uit te leggen hoe het algoritme werkt. Dit is namelijk een wiskundige functie. Dit algoritme vormt samen met de trainingsdata een model waar deze regels in opgesloten liggen. Deze regels zijn niet inzichtelijk en niet controleerbaar. Daarom spreken we van een ‘black box’. Met Explainable AI proberen we deze regels te achterhalen.

Waarom Explainable AI?

De inzet van Explainable AI vergt een verandering van het ontwerp- en ontwikkelproces van AI systemen. Er zijn vier belangrijke redenen waarom we dit willen:

Wat is explainable AI? In deze video vertelt Joop Snijder, Head of Research Center AI bij Info Support je alles wat je moet weten over explainable AI.

Algoritmen worden nog steeds door mensen gemaakt, en die algoritmen zijn nog steeds gekoppeld aan menselijke vooroordelen. Het zijn slechts geautomatiseerde aannames. En als je de vooroordelen niet oplost, automatiseer je gewoon de vooroordelenRep. Alexandria Ocasio-Cortez

Explainable AI in de praktijk

Waar kunt u Explainable AI inzetten en welke invloed heeft dat op uw processen? De volgende praktijkcases laten voorbeelden zien in verschillende bedrijfssectoren.

Case 1: Onderzoeksproject NL4XAI

Info Support is een business partner in het Europese onderzoeksproject genaamd ‘Interactive Natural Language Technology for Explainable AI’, afgekort NL4XAI. In dit project gaan we de uitdaging aan om AI zelf verklarend te maken…

Case 2: Vertrouwen in een model

Het succes van een AI-model hangt niet alleen af van hoe nauwkeurig deze is. De gebruikers van het model moeten de uitkomsten vertrouwen. In sommige gevallen maakt het u niet uit waarom een beslissing is genomen…

Case 3: Klantbehoud

Klantbehoud is een belangrijk thema in verschillende sectoren, waar loyale klanten geld opleveren en het aantrekken van nieuwe klanten een investering vergt. Denk hierbij aan markten waar klanten eenvoudig overstappen naar een concurrent…

Case 4: Online credit check

Bij het aanvragen van een krediet wil u snel weten of u hiervoor in aanmerking komt. U kunt u voorstellen dat het handig is om geautomatiseerd de uitkomst van een credit check…

Case 5: Foutopsporing in het OV

In het openbaar vervoer zijn de kosten van brandstof en elektriciteit van grote invloed op het rendabel houden van uw bedrijf. Daarom is het bijvoorbeeld handig om machinisten te ondersteunen bij het besturen van de trein…

Zelf starten met Explainable AI

Maak Explainable AI onderdeel van uw dagelijkse routine binnen het ontwikkelproces. Er zijn diverse momenten waarop explainers helpen.

- Tijdens het pre-processen om fairness te meten

- Tijdens het trainen om fouten op te sporen

- Tijdens het testen om het model te valideren

- Tijdens productie om het model te monitoren

U hoeft niet alle vormen van Explainable AI op alle mogelijke momenten in het proces vanaf dag 1 toe te passen. Ons advies: start met het inzetten van explainers tijdens het testen van modellen.

Naast het verzamelen van metrieken, kunt u vrij eenvoudig in uw trainingsscript een explainer opnemen, zodat u niet alleen de nauwkeurigheid van uw model meet, maar ook direct ziet waarom die nauwkeurigheid wordt behaald.

Responsible AI Workflow

Explainers zijn het beste in de dagelijkse routine te krijgen door een vaste workflow. Binnen onze Responsible AI Workflow zitten vaste punten om explainers te gebruiken. Download ons whitepaper om de Responsible AI Workflow te bekijken.

Tools voor Explainable AI

Het toevoegen van een explainer aan uw model validatie/tests is eenvoudig, omdat er goede tools beschikbaar zijn.

De volgende tools bieden een breed scala aan explainers aan, waarmee u eenvoudig start binnen een bestaande python ontwikkelomgeving:

- InterpretML – Een bibliotheek ontwikkeld vanuit een groep wetenschappers, waaronder onderzoekers vanuit Microsoft.

- Alibi – Deze bibliotheek is ontwikkeld vanuit het open source project voor MLOps, Seldon.io.

Het is ook goed om te weten dat u beide tools in combinatie met MLOps tools zoals Azure Machine Learning Service kunt gebruiken. Indien u MLOps toepast in uw bedrijf is het eenvoudig starten met explainers.

Toepassing van explainers door verschillende disciplines

Het lijkt logisch dat explainers worden toegepast door data scientists, maar ze zijn niet alleen nuttig voor die discipline. Ook machine learning engineers kunnen explainers goed inzetten om fouten tijdens het trainen op te sporen.

Het gebruik van explainers moet groeien!

Aan het begin van dit hoofdstuk gaven we aan dat u het beste kan beginnen met het toepassen van explainers tijdens het testen.

U zult merken dat u snel meer toepassingen vindt. Zoals voor het debuggen van fouten.

We hebben in de praktijk gezien dat explainers die eerst werden gebruikt voor testen, later ook in productie worden ingezet te worden voor het monitoren van het model.

We raden teams die beginnen met Explainable AI aan om te experimenteren en kennis te delen. Vooral omdat het een jonge techniek is, waar veel in veranderd.

Verschillende vormen van Explainable AI

Er zijn diverse manieren om modellen te interpreteren of uit te leggen met Explainable AI.

Globale en lokale uitleg

U kan de uitleg van een model op twee niveaus geven: op globaal niveau en op lokaal niveau. Globaal kunt u iets zeggen over hoe het model omgaat met een gemiddeld data sample. Wilt u meer details dan zet u local explanations in. Deze geven meer inzicht in individuele data samples.

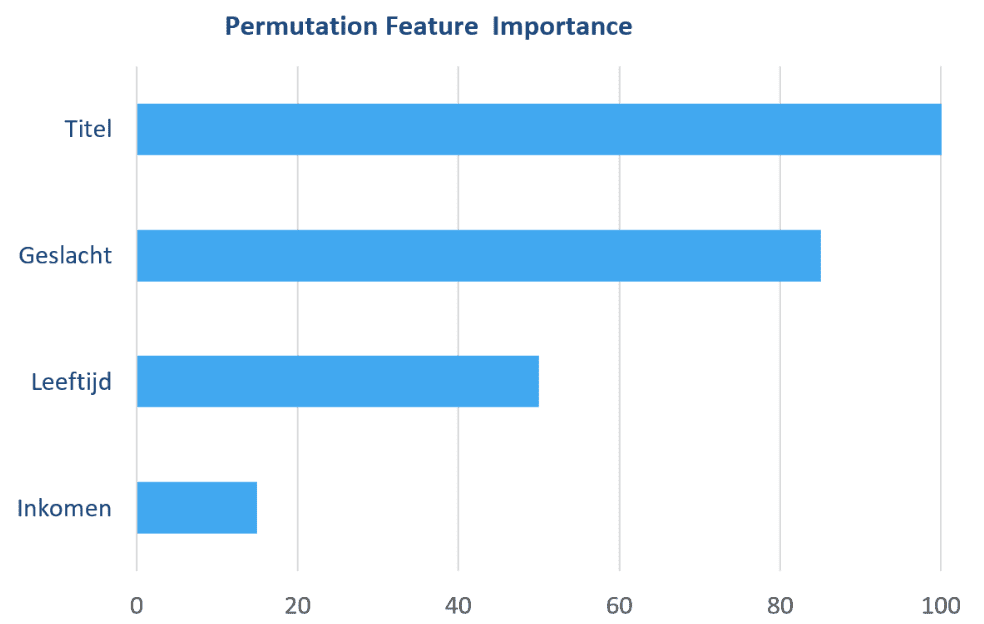

Modellen uitleggen met feature importance

De kern van Explainable AI draait om het bepalen welke invloed bepaalde input heeft op de uitkomst van het model voor een gemiddeld data sample. Met behulp van permutation feature importance kunt u zien wat de invloed is van de input op de uitkomst van het model op globaal niveau.

Met partial dependence plots kunt u vervolgens inzoomen op een enkele input en iets zeggen over wat daar de invloed van is op de uitkomst.

Uitleg van individuele data samples

In de vorige sectie hebben we het vooral gehad over uitleg op globaal niveau. Dit geeft niet een compleet beeld. Het kan namelijk per data sample verschillen hoe het model reageert. De partial dependence plot geeft hier iets meer inzicht in, maar er zijn andere methodes die hier beter in zijn.

Voor meer vertrouwen in uw model, of om specifieke gevallen uit te leggen helpt het maken van een local explanation.

U kan hiervoor bijvoorbeeld SHAP inzetten. Met SHAP kunt u voor een enkel data sample bepalen wat elke individuele input heeft bijgedragen aan de uitkomst van het model.

Waar u dus op globaal niveau een algemene structuur terug krijgt van uw model, krijgt u op lokaal niveau het waarom achter een specifieke voorspelling.

Fouten opsporen met explainers

Naast de uitleg van de structuur van uw model en het waarom achter een voorspelling, is het ook zinvol om bij een foute voorspelling te achterhalen wat de oorzaak is.

Met counterfactual explanations krijgt u meer inzicht in welke waarde, ervoor zorgde dat uw model een verkeerde voorspelling maakte.

Met counterfactual explanations vindt u de grenzen van uw model, zodat u gerichter data kan verzamelen om de grensgevallen beter te voorspellen.

Een andere manier om fouten op te sporen is door gebruik te maken van anchors. Met deze methode bepaalt u welke input als anker functioneert. Een anker heeft grote invloed op de uitkomst van het model. Alle andere gegevens doen er bijna niet toe als u een sterk anker hebt. Als u weet wat uw anker is, dan kunt u gerichter data verzamelen die de juiste gegevens bevat om uw model te verbeteren.

Info Support Research Center AI

Info Support is de specialist in het ontwikkelen van hoogwaardige softwareoplossingen en leidend op het gebied van kunstmatige intelligentie (AI), dataoplossingen, cloud architectuur, Managed Services en IT-trainingen. Met een agile mentaliteit en software crafstmanship helpen ruim 500 professionals klanten vooruit in de sectoren agrifood, retail, energie, fintech, mobiliteit, pensioen en zorg. ?

Info Support Research Center AI?

Info Support loopt vooruit op aankomende en toekomstige uitdagingen en zorgt ervoor dat onze professionals geavanceerde oplossingen ontwikkelen met de laatste wetenschappelijke inzichten. Onze research community pakt opkomende technologieën actief aan. We doen dit samen met gerenommeerde wetenschappers?

3 Onderzoekslijnen?

Binnen ons Research Center AI hebben we drie onderzoekslijnen:?

- Explainable AI?

- Advanced Machine Learning?

- Natural Language Processing voor het Nederlands

Explainable AI whitepaper

Wilt u meer weten over het onderwerp Explainable AI? Uitleg van AI-modellen voor iedereen. Alles wat op deze pagina staat en meer vindt u in ons whitepaper Explainable AI.

Meer weten?

Wilt u meer weten over wat Explainable AI voor uw organisatie kan betekenen of hoe Info Support u op het gebied van AI kan helpen? Neem dan via onderstaand formulier contact met ons op.