Interpretable AI en Explainable AI

Dit artikel is onderdeel van een driedelige serie geschreven door Joop Snijder. Meer informatie is terug te vinden in het artikel: AI kan niet meer zonder uitleg daarnaast is er een checklist beschikbaar in het artikel: Checklist: Hoe kies je tussen Interpretable AI en Explainable AI?

Er zijn twee verschillende technieken die gebruikt worden om uitleg te geven aan AI-modellen. Om te begrijpen waarom er twee technieken zijn voor het geven van uitleg en hoe dit werkt, Kijken we eerst naar hoe AI-systemen leren.

Hoe leren AI-systemen?

AI-systemen optimaliseren hun gedrag om te voldoen aan een wiskundig gespecificeerd algoritme, gekozen door de ontwikkelaar, zoals “maximaliseer de nauwkeurigheid van het bepalen van huizenprijzen”. De AI kan nuttige algemene regels uit de gegevens leren, zoals “beoordelingen met het woord ‘verschrikkelijk’” zijn waarschijnlijk negatief. Het kan echter ook ongewenste regels leren, zoals “beoordelingen met ‘Will Smith ‘zijn meestal positief”. Dit algoritme vormt samen met de trainingsdata een model waar deze regels in opgesloten liggen. Afhankelijk van het soort algoritme zijn deze regels doorzichtig of niet. We maken daarom onderscheid tussen black-box modellen en white-box (interpreteerbare) modellen. White-box modellen zijn machine learning modellen die resultaten opleveren die begrijpelijk zijn voor experts in het domein. De uitleg van de geleerde regels zijn eenvoudig te achterhalen.

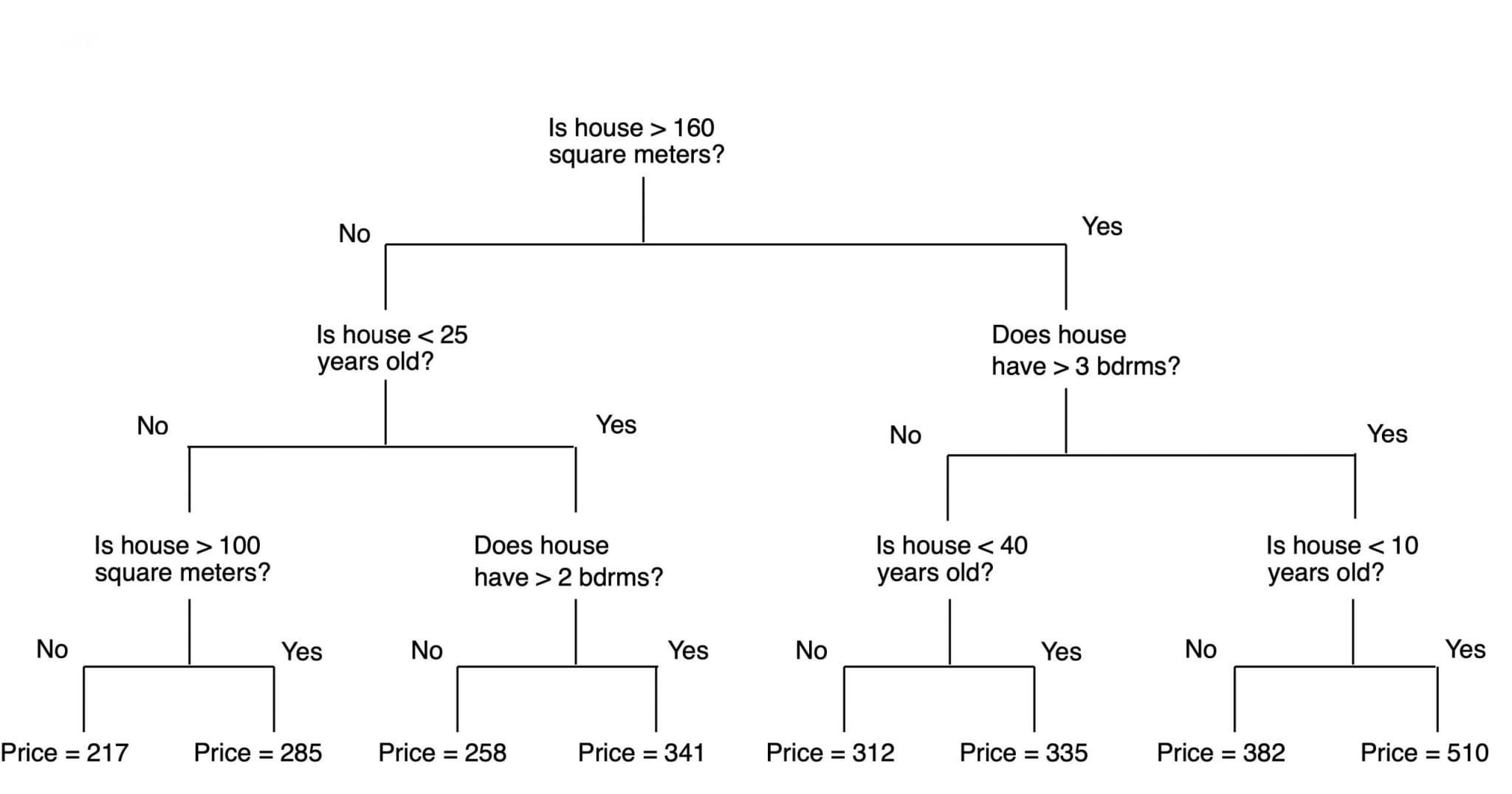

Deze modellen zijn intrinsiek uitlegbaar en daarom zelf in staat zijn om uitleg te geven. Deze techniek wordt Interpretable Machine Learning of Interpretable AI genoemd. Modellen gebaseerd op decision trees of lineaire regressie zijn hier een voorbeeld van.

Een decision tree is een algoritme dat input waardes opsplitst in vertakkingen op beslissingsknooppunten, zie onderstaande afbeelding. De uitleg van een decision tree kan er als volgt uitzien zoals in voor het bepalen van huizenprijzen:

Black-box modellen

Voor black-box modellen geldt juist dat de geleerde regels niet inzichtelijk zijn en niet zomaar controleerbaar. Om toch een inschatting van de geleerde regels te maken, wordt gebruik gemaakt van Explainable AI. Er zijn diverse manieren om modellen te interpreteren of uit te leggen met Explainable AI. Je kan de uitleg van een model op twee niveaus geven: op globaal niveau en op lokaal niveau. Globaal kunt je iets zeggen over hoe het model omgaat met een gemiddeld datavoorbeeld. Wil je meer details dan zet je lokale uitleg in, zoals met het voorbeeld van de voorspelde waarde van Cristiano Ronaldo. Dit geeft meer inzicht in individuele uitkomsten van een model. Explainable AI-tools werken op verschillende manieren, maar om het eenvoudig te houden kunnen we het uitleggen als volgt:

- Een deel van de trainingsdata of een surrogaat dataset wordt geselecteerd.

- Hiermee neemt de Explainable AI-tool monsters uit het model en krijgt uitkomsten terug.

- Op basis van de monsters wordt geprobeerd om de uitkomsten te verklaren.

Interpretable AI als onderdeel van Explainable AI?

Er is geen overeenstemming binnen de literatuur of Interpretable machine learning onderdeel is van Explainable AI of dat het twee verschillende technieken zijn. Voor dit artikel is het belangrijk om de technieken te begrijpen en laten we de discussie over definities voor wat het is. Uiteindelijk willen we modellen transparanter krijgen met goede uitleg.

Het lijkt logisch om alleen gebruik te maken van Interpretable AI. Een dergelijk model is zelf in staat om uitleg te geven, dus waarom kiezen we daar niet standaard voor?

Daar zijn verschillende redenen voor. Om die goed te doorgronden, moeten we kijken naar de verschillen tussen Interpretable AI en Explainable AI. In de tabel hieronder hebben we de verschillen naast elkaar gezet.

EXPLAINABLE AI

Wanneer je een black-box model gebruikt en achteraf deze uitlegt

Uitleg komt van surrogaat model

Uitleg wordt achterhaald door het model eenvoudiger na te maken.

Model onafhankelijk

De uitleg is model onafhankelijk. De gebruikte Explainable AI-tool is op dezelfde manier te gebruiken voor gelijksoortige modellen.

Verschillende tools kunnen wel verschillende uitlegvormen geven.

Schatting van redenatie van het model

Omdat de uitleg vanuit een surrogaatmodel of surrogaatdata komt, is het een inschatting van de redenatie van het model. De werkelijke werking van het model kan op sommige punten flink afwijken.

Goed onderliggend model maken is eenvoudig

Het trainen van een black-box model is eenvoudig, omdat het model uitzoekt wat relevante factoren zijn om van te leren.

Uitleg maken is rekenintensief

Voor iedere uitleg moeten veel berekeningen worden gemaakt. Dit maakt deze techniek rekenintensief en heeft invloed op de snelheid en kosten.

Eenvoudig voor deep learning

Deep learning wordt gebruikt voor foto’s, audio en video omdat het daar zeer geschikt voor is. Er zijn veel verschillende Explainable AI-tools beschikbaar hiervoor.

INTERPRETABLE AI

Wanneer je een model gebruikt dat geen black-box is

Uitleg komt uit model

Uitleg is uit de structuur van het model te halen.

Model specifiek

Hoe je uitleg krijgt en hoe de uitleg eruitziet, is afhankelijk van het gekozen algoritme. Omdat de uitleg uit het model komt, is per model verschillend.

Exacte weergave van redenatie van het model

Omdat de uitleg uit het model komt, is de uitleg een exacte weergave van de redenatie van het model.

Goed model maken is lastig

Een goed interpreteerbaar model maken is moeilijker dan een black- box model maken. Een data scientist moet onderzoeken wat relevante factoren zijn waarop een model getraind wordt. Dit is arbeidsintensief..

Uitleg maken niet rekenintensief

Omdat de uitleg direct uit het model is te halen, is het maken van de uitleg niet rekenintensief.

Complex voor foto’s, audio en video

Er zijn technieken in de maak voor interpreteerbare modellen voor foto’s, audio en video. Het aanpassen van deze modellen is

nog complex en zeer specialistisch.

Kiezen tussen de modellen

De vraag is nu, hoe kies je tussen Interpretable AI en Explainable AI? Het antwoord op de vraag is niet zo eenvoudig. Misschien alleen voor hoog-risico systemen en systemen die een grote impact kunnen hebben, is het duidelijk. Daar wil je, indien mogelijk, kiezen voor Interpretable AI. De uitleg is van zo’n groot belang, dat je alles probeert om het AI-systeem interpreteerbaar te maken. Een advies is om altijd eerst interpreteerbare modellen te kiezen boven modellen die achteraf uitgelegd moeten worden. Uiteindelijk zijn deze modellen vaak beter qua performance en zullen sneller geadopteerd worden door de transparantie.

Daarnaast moet je rekening houden aan wie je uitleg geeft. Wie is je publiek waar je je uitleg op richt? Bijvoorbeeld:

- Personeel wiens beslissingen worden ondersteund door het AI-systeem en die zinvolle informatie moeten doorgeven aan een persoon die wordt getroffen door de AI-ondersteunde beslissingen;

- Degenen die door de beslissing worden getroffen, met bijzondere aandacht voor:

- Kwetsbare groepen; en

- Kinderen; of

- Auditors of externe reviewers die belast zijn met het monitoren van of toezicht houden op de productie en implementatie van het AI-systeem

Om een gedegen keuze te maken, hebben we een checklist gemaakt.

Naar de checklist:

Checklist: het selecteren van een toepasselijk uitlegmodel

De uitdaging bij het geven van uitleg over de modellen

De techniek van Explainable AI is in ontwikkeling. Internationaal wordt wetenschappelijk onderzoek gedaan naar het verbeteren van Explainable AI. Op het moment van schrijven is de uitleg van Explainable AI vooral begrijpelijk voor experts. De uitleg bestaat uit grafieken en scores, die geïnterpreteerd worden door experts. Voor de democratisering van AI is het van belang dat de uitleg begrijpelijk wordt voor iedereen. Hiervoor is het nodig om de technische uitleg te vertalen naar natuurlijke en begrijpelijke taal, het liefst afgestemd op de gebruiker. Hier komt naast de technieken en uitkomsten van Explainable AI en Interpretable AI voornamelijk design kijken. Het is een uitdaging om de technische mogelijkheden om te zetten naar begrijpbare uitleg voor de gebruikers. Om effectief te zijn, moet uitleg voor mensen begrijpelijk zijn, en dit vereist een mix van Explainable of Interpretable AI-technieken en human-centered design.

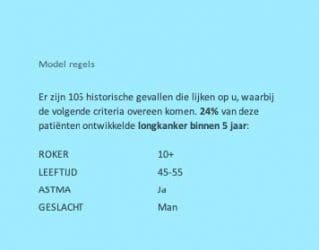

We hebben in het artikel AI kan niet meer zonder uitleg bij de uitleg van de voorspelling van de waarden van Cristiano Ronaldo gezien dat uitleg die uit uitlegtechnieken komt voor de meeste mensen erg technisch en niet direct begrijpelijk is. Per AI-model moet dan gekeken worden hoe je de uitleg vertaalt van een technische uitkomst van het model, naar een begrijpelijke uitleg voor de beoogde doelgroep. Stel: we hebben een model dat voorspelt of een patiënt een hoog risico heeft op longkanker. We willen uitleggen hoe de voorspelling tot stand is gekomen. We kunnen dan de technische uitleg leesbaarder maken. Dit is te zien in de onderstaande afbeelding.De factoren die invloed hebben gehad op de voorspelling zien er niet technisch uit. De grafiek met balken, kleuren en lijnen is vervangen door eenvoudige tekst. Zie hieronder het voorbeeld van het longonderzoek.

Om de uitleg begrijpelijk te maken, kijken we goed naar de doelgroep. Dit zijn in dit voorbeeld de patiënten. Als patiënt wil je soms niet weten wat deze voorspelling voor je betekent.

In dat geval is het belangrijker om de uitleg te schrijven en aan te geven wat de impact is voor de patiënt, zonder al drastische conclusies te tonen. De belangrijkste factoren die invloed hebben gehad op de voorspelling kunnen voor de patiënt worden geselecteerd en samen met de redenatie van het model, wordt de impact van de voorspelling begrijpbaar.

Zoals we zien geeft de redenatie en de belangrijkste factoren meer duidelijkheid aan de patiënt wat de risico’s zijn. Maar wellicht heeft de patiënt nog de vraag of hij of zij iets kan doen om de risico’s te verlagen. Op basis van dezelfde technische uitleg kan een andere begrijpelijke uitleg aan de patiënt worden gegeven, zoals dat de patiënt een gezonder dieet kan volgen. Op basis daarvan kan vanuit het AI-modelberekend worden met hoeveel procent de risico oplongkanker kan afnemen. Een van de grootste uitdagingen is zoals we zien de vertaling van technische uitleg naar begrijpelijke uitleg. De specialismen van Interpretable AI en Explainable AI zijn jonge technieken waar veel in verandert. De wetenschap zoekt zowel naar verbeteringen in de technische uitleg als in de vertaling van deze vorm van uitleg.

In de onderstaande afbeelding is de uitleg gespecifieerd voor een bepaald patiënt. Hierin staat dus alleen de voorspelling die voor de patiënt van toepassing is.

Relevante informatie met betrekking tot AI

In het artikel AI kan niet meer zonder uitleg staat meer informatie over de uitleg van de AI-modellen. Om te kiezen welk AI-model het best toepasbaar is binnen uw organisatie is er de volgende Checklist samengesteld: Checklist: het selecteren van een toepasselijk uitlegmodel

Joop Snijder

Head of Research Center

Toonaangevend expert op het gebied van kunstmatige intelligentie (AI) en momenteel Chief Technology Officer (CTO) van Aigency, een AI-expertiselabel van Info Support. Met meer dan 10 jaar ervaring in AI is Joop een gepassioneerd voorstander van uitlegbare en interpreteerbare AI, die bedrijven helpt de kracht van deze geavanceerde technologie te benutten om innovatie en groei te stimuleren.